Sooftware Speech - Pushing the Limits of Semi-Supervised Learning for Automatic Speech Recognition Paper Review

Pushing the Limits of Semi-Supervised Learning for Automatic Speech Recognition

Yu Zhang et al., 2020

Google Research, Brain Team

Reference

Summary

- 현재 Papers with Code 기준 ASR 부문 State-Of-The-Art

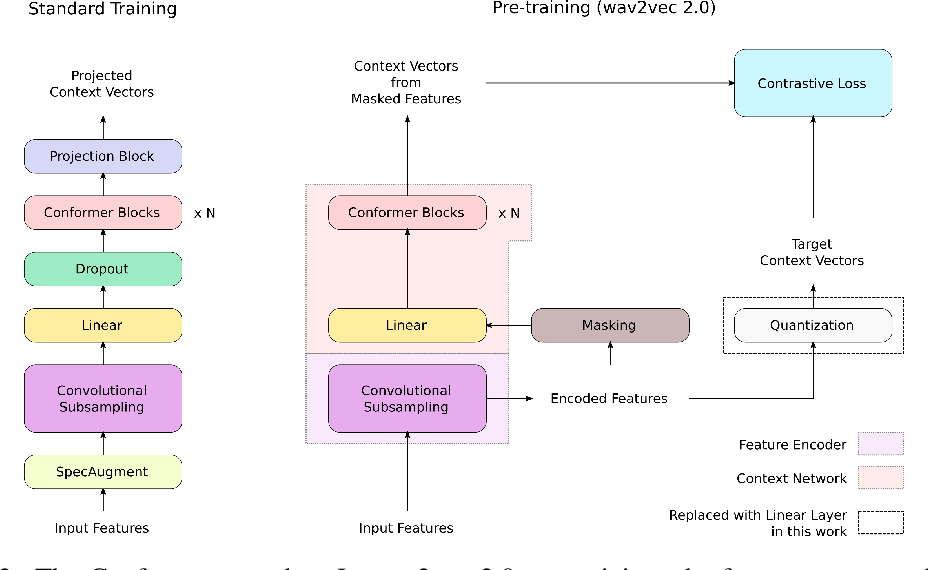

- Conformer + Wav2vec 2.0 + Noisy Student Training

- 1.3%/2.6%/1.4%/2.6% on the dev/dev-other/test/test-other sets

Wav2vec 2.0 Pre-training

- 53,000이라는 대량의 Unlabeled speech data로 학습

- Pre-training 과정

- Waveform에서 CNN을 이용해서 피쳐를 뽑음

- 이를 Vector Quantization을 통해 one-hot-vector로 만들고 Embedding matrix를 내적하여 token화 함

- 일정 비율로 Masking하고 다음 Token이 뭔지 알아맞추게하는 Masked Language Modeling (MLM) 학습 방식 적용

- Vector Quantization

Conformer

- Self-attention 기반한 트랜스포머는 global-context 정보를 잘 표현하지만, local-context에서는 부족하다는 단점이 있음

- 반면, CNN 기반 모델은 local-context는 잘 표현하지만 global-context를 반영하기 위해서는 적당한 dilation과 깊은 구조를 가져야 함

- 이 두 방법을 결합하여 global-context와 local-context 모두 잘 표현할 수 있도록 하기 위한 transformer + CNN 결합구조인 Conformer 구조 제안

Method

본 논문에서 실험한 모델 구조 및 트레이닝 방법

Model Architecture

Conformer Encoder + LSTM decoder로 이루어진 Transducer 구조

- 기존 Conformer 구조에서 Wav2vec 2.0 Pre-training을 도입하기 위해 Masking하는 과정과 Linear Layer (Quantization 대체) 추가

- 사이즈별로 L, XL, XXL로 구분

- XXL+는 Conformer XXL에 Conformer block을 stack (XXL보다 50M 파라미터 추가)

Wav2vec 2.0 Pre-training

- 60k Libri-Light 데이터셋 사용

- 기존 논문과 달리, 인풋으로 log-mel spectrogram 사용

- Masking 된 인풋과 예측한 context vector 간의 contrastive loss로 학습

Noisy Student Training with SpecAugment

Experiiments

- 결과적으로 Pre-training + NST가 좋은 성적을 냄

Subscribe to SOOFTWARE

Get the latest posts delivered right to your inbox